Instalação e Uso de LLMs Offline no Android pt.1

Outros posts sobre o tema em:

Como Criar um Pipeline em Python para Testar Modelos no Hugging Face

Parte 1 - Instalando o Ollama no Linux

Parte 2 - Instalando o Ollama no Windows

Parte 4 - Instalando LLMs Off-line no Android - pt.2

Parte 5 - Quatro Maneiras de Usar LLMs Offline no Seu Computador

Parte 6 - RAG Offline: Usando LM Studio e Ollama para Processar Documentos

Importante: Nunca utilizar LLMs como oráculos ou como fonte de informações, já encontrei vários erros tanto em modelos online ou offline. Usar apenas como suporte para suas atividades.

Depois de testar LLMs offlines no computador, resolvi procurar uma solução para meu celular. O dispositivo em questão é um celular Android da Marca Samsung modelo A15 (SM-A155M/DSN). O mesmo é um dispositivo que me custou um pouco menos de 1000 reais e o possui 8 gigas de RAM, em meus testes a quantidade de RAM influenciou no desempenho, com 8 GB tive sucesso em modelos de no máximo 4B de paramêtros, testei um de 7B e ele ficou muito lerdo para gerar a inferência. Sobre dispositivos com 4 gigas de RAM fiz um teste e descrevo no item 15.

Existe bastante discussões sobre este tema, como por exemplo em onde conheci este aplicativo, o LM Playground.

Lembrando que é uma solução experimental e encontrei vários problemas como demora de respostas e muitas vezes ele alucinava ou não finalizava a inferência. Dependendo o poder computacional do dispositivo onde está sendo realizado o teste, ele pode não conseguir inferir dependendo o modelo LLMs. Testei um Modelo de 7B no meu celular e ele ficou muito lento.

Caso queira ver o aplicativo em ação, segue um vídeo que gravei testando o aplicativo:

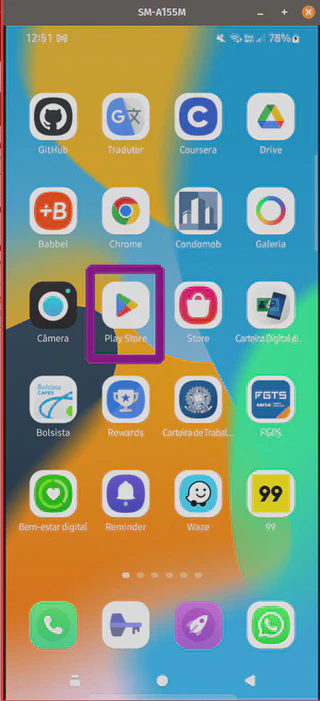

Para instalar:

- Entrar na PlayStore:

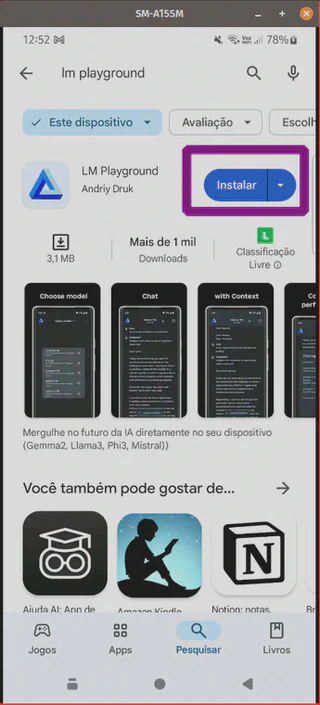

- Procurar o Aplicativo “LM Playgroung”:

- Instalar o App:

Para utilizar o Aplicativo:

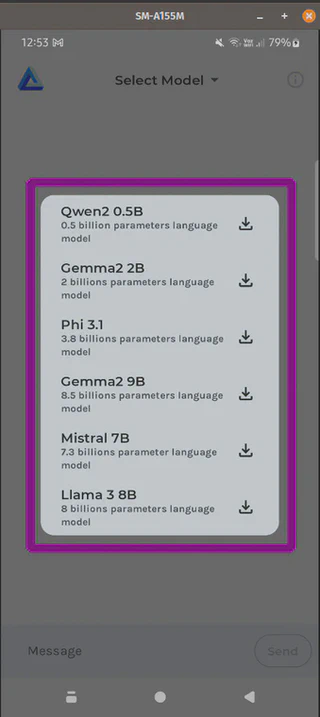

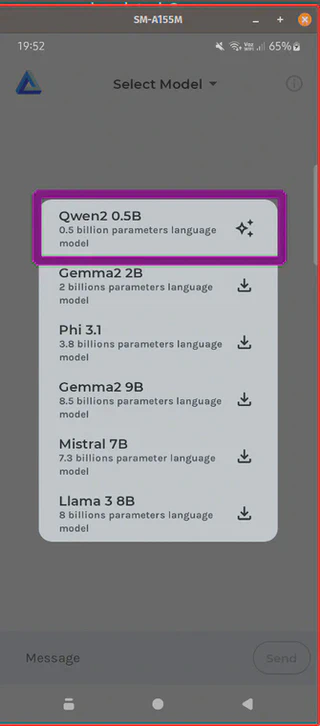

- Abrir o App e clicar em “Select Model”:

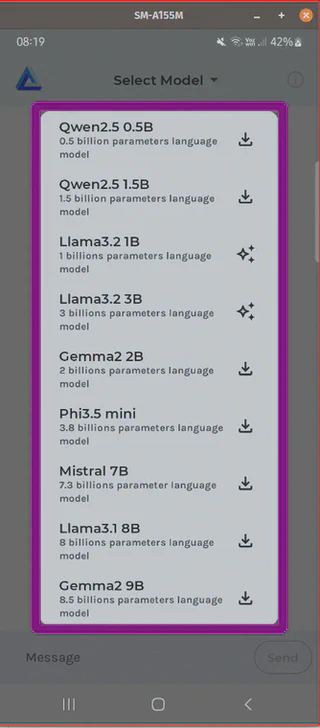

- Abrira os modelos disponíveis no aplicativo, lembrando que a versão Beta do aplicativo possui mais modelos disponíveis, ver item 13:

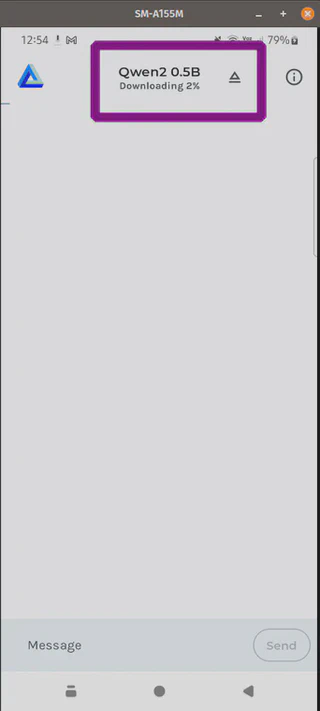

- Clicar em baixar um modelo e esperar baixar:

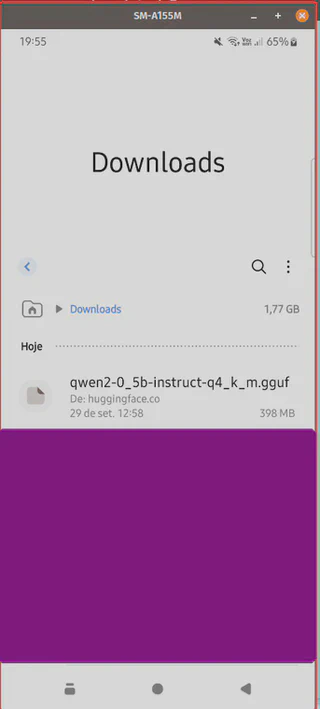

- Aparecerá que o modelo foi baixado:

- O Aplicativo baixa o modelo na pasta de Download, se você quiser apagar um modelo baixado, precisa deletar no seu gerenciador de dispositivos:

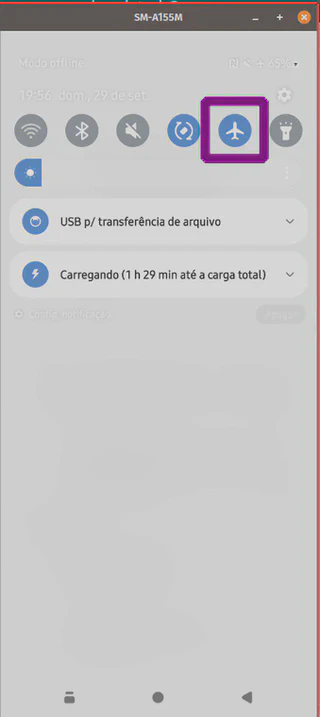

- Para garantir que não ocorra conexão, para fins de teste:

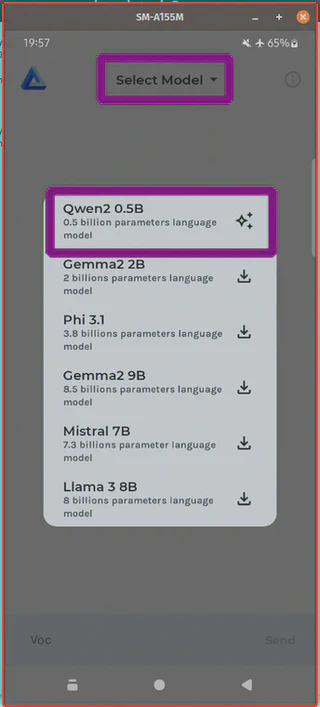

- Abrir novamente o aplicativo e escolher o modelo:

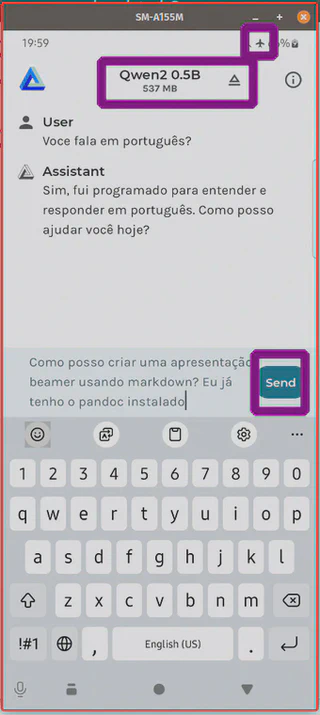

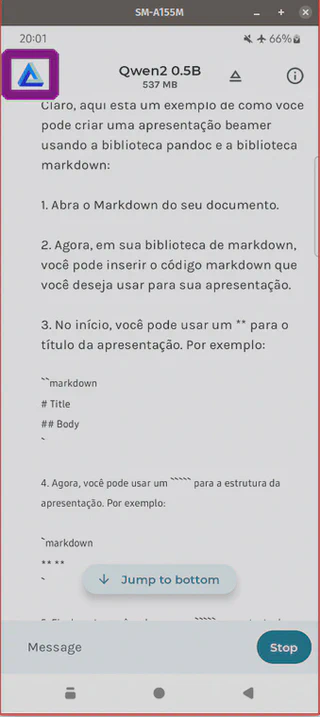

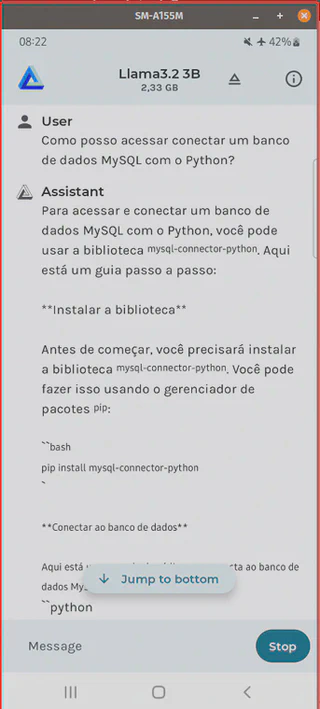

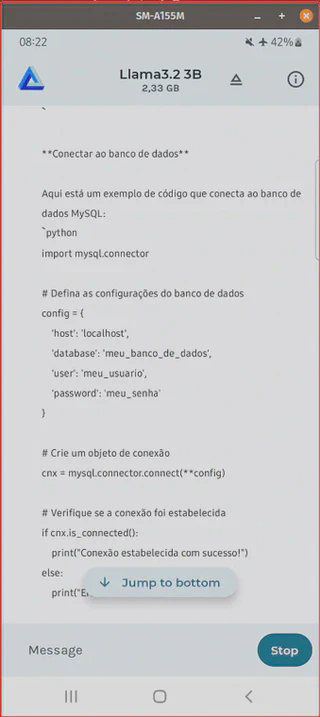

- Agora você pode começar a utilizar o modelo como se fosse um chat.

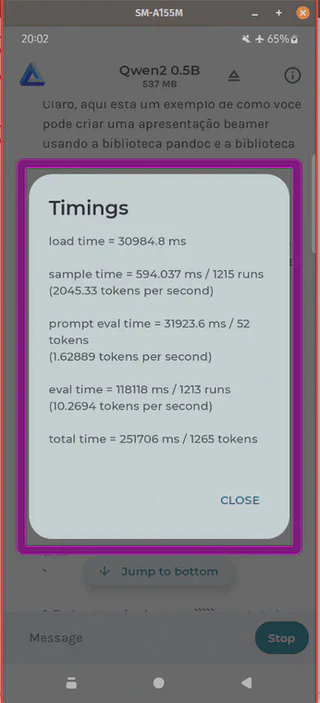

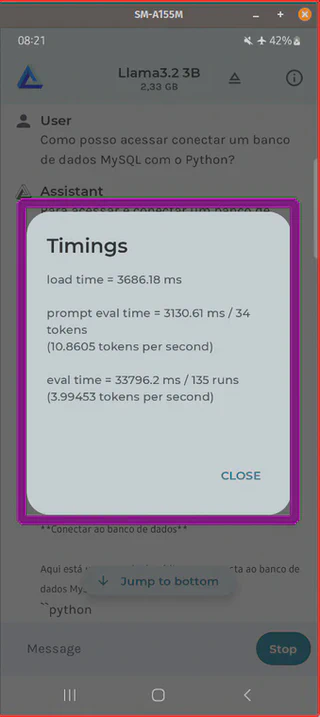

- Ao clicar no símbolo do aplicativo ou no sinal de exclamação, você pode avaliar a métrica de performance do modelo:

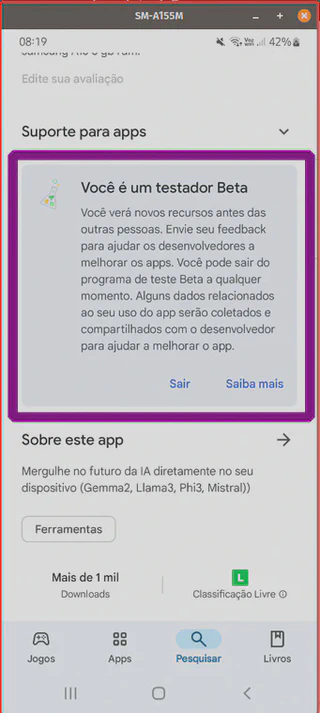

- Entrei como testador beta do LM Playground e após a atualização do aplicativo apareceu novos modelos LLMs para testar:

- Testei a Llama3.2 3B e gostei do desempenho em meu celular:

- testei em um tablet da Samsung (Modelo X200 com 4 GB de RAM) e não tive sucesso com este modelo de Llama3.2 3B, mas aparentemente o Llama3.2 1B funcionou bem, reforçando a questão empírica destes testes:

Sucesso a todos!